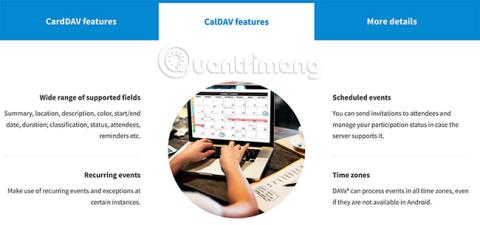

Come sincronizzare CalDAV e CardDAV con Android

Scopri come sincronizzare CalDAV e CardDAV su Android per gestire efficacemente i tuoi dati di calendario e contatti.

Recentemente ci siamo imbattuti spesso nella frase sensore LiDAR negli articoli sulle fotocamere dei nuovi dispositivi Apple. Questa frase è così diffusa che dimentichiamo che i telefoni con Realtà Aumentata possono funzionare in qualsiasi modo, specialmente con gli strumenti ToF che portano i telefoni Samsung a un livello superiore.

Allora dov’è la differenza tra LiDAR e ToF? Scopriamolo con Quantrimang.

Cos'è il ToF?

ToF sta per Tempo di volo. In realtà, il ToF coinvolge la velocità della luce (o anche del suono) per determinare la distanza. Misura il tempo impiegato dalla luce per lasciare il dispositivo, raggiungere l'oggetto e ritornare, il tutto diviso in due periodi che indicano la distanza dal dispositivo all'oggetto o alla superficie.

I dispositivi Android utilizzano sensori ToF

Quindi tutto il LiDAR è un tipo di Time of Flight, ma non tutto il ToF è LiDAR. In poche parole, ToF significa misurazione della distanza ottica, che non è correlata al LiDAR.

LiDAR sta per Light Detection and Ranging. Questa tecnologia utilizza un laser, o un raggio laser, nonché una sorgente luminosa simile a quella sopra.

Sensore LiDAR su iPhone

È possibile utilizzare un singolo sensore LiDAR per misurare la larghezza di una stanza, ma è possibile utilizzare più sensori LiDAR per creare una “nuvola di punti”. Questi punti vengono utilizzati per creare un modello 3D di un oggetto o una mappa topografica di un'intera area.

Sebbene LiDAR possa essere una novità per i dispositivi mobili, la tecnologia in realtà esiste già da un po’. Quando non è installato su un telefono, LiDAR viene utilizzato per fare qualsiasi cosa, dalla mappatura degli ambienti sottomarini ai siti archeologici.

Differenza tra LiDAR e ToF

La differenza funzionale tra LiDAR e altre forme di ToF è che LiDAR utilizza un laser pulsato per costruire una “nuvola di punti”, che viene poi utilizzata per costruire una mappa o un’immagine 3D. Le applicazioni ToF creano "mappe di profondità" basate sul rilevamento della luce, spesso tramite una fotocamera RGB standard.

Il vantaggio di ToF rispetto a LiDAR è che ToF richiede apparecchiature meno specializzate, quindi può essere utilizzato con dispositivi piccoli e meno costosi. Il vantaggio di LiDAR deriva dal fatto che i computer possono leggere facilmente le nuvole di punti relative alle mappe di profondità.

L'API Depth creata da Google per Android funziona meglio sui dispositivi che supportano ToF, creando una mappa di profondità e riconoscendo i "punti caratteristici". Questi punti caratteristici sono spesso barriere tra diverse intensità di luce, che vengono poi utilizzate per definire diversi piani nell'ambiente. Ciò crea essenzialmente una nuvola di punti a risoluzione inferiore.

Come funzionano ToF e LiDAR con l'AR mobile

Le mappe di profondità e le nuvole di punti sono fantastiche e per alcuni utenti sono sufficienti. Tuttavia, per la maggior parte delle applicazioni AR, questi dati devono essere contestualizzati. Sia ToF che LiDAR raggiungono questo obiettivo lavorando in combinazione con altri sensori su dispositivi mobili. Nello specifico, queste piattaforme devono comprendere l'orientamento e il movimento del tuo telefono.

LiDAR è migliore di ToF?

Per essere precisi, LiDAR è più veloce e preciso di ToF. Tuttavia, questo diventa più importante con le nuove applicazioni tecnologiche.

Ad esempio, le API ToF e Depth di Google hanno difficoltà a comprendere piani grandi e con texture bassa come i muri bianchi. Ciò può rendere difficile per le applicazioni che utilizzano questo metodo posizionare con precisione oggetti digitali su determinate superfici nel mondo fisico. Le applicazioni che utilizzano LiDAR hanno meno probabilità di avere questo problema.

Tuttavia, è improbabile che le applicazioni che coinvolgono ambienti strutturalmente diversi o più ampi presentino questo problema. Inoltre, la maggior parte delle applicazioni AR consumer basate su dispositivi mobili utilizzano filtri AR sul viso o sul corpo dell'utente, un'applicazione che difficilmente incontrerà problemi a causa delle grandi superfici strutturate.

Perché Apple e Google utilizzano sensori di profondità diversi?

Nel rilasciare dispositivi compatibili con LiDAR, Apple afferma di aver combinato i sensori con l'hardware per "aprire flussi di lavoro più professionali, supportando applicazioni fotografiche e video professionali". L'iPad Pro compatibile con LiDAR è "il miglior dispositivo al mondo per la realtà aumentata" e il prodotto di lancio include le app di misurazione di Apple.

Google spiega a lungo perché la loro API Depth e la nuova linea di dispositivi di supporto non utilizzano LiDAR. Lavorare con LiDAR mantiene i dispositivi Android più leggeri e convenienti, inoltre c'è un grande vantaggio in termini di accessibilità.

Poiché i telefoni Android sono prodotti da molte aziende, l’adozione di LiDAR favorirà i modelli compatibili con LiDAR rispetto ad altri. Inoltre, poiché richiede solo una fotocamera standard, l'API Depth è retrocompatibile con più dispositivi.

Scopri come sincronizzare CalDAV e CardDAV su Android per gestire efficacemente i tuoi dati di calendario e contatti.

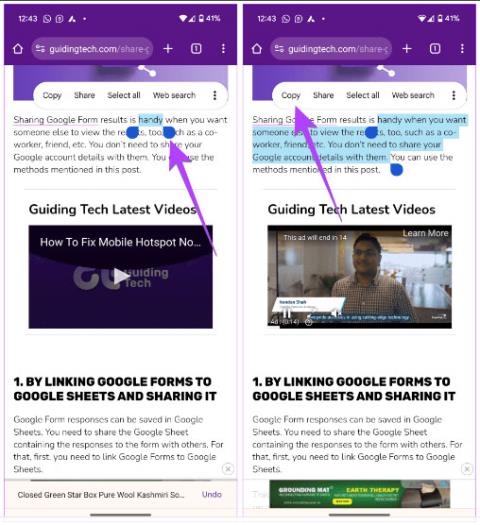

Scopri come accedere agli appunti su Android con Gboard, SwiftKey, e Samsung Keyboard. Ottimizza la tua esperienza di copia e incolla!

Con i dispositivi Android, puoi scaricare facilmente i contenuti Netflix su una scheda SD esterna anziché sulla memoria interna. Impariamo con Quantrimang come convertire i contenuti scaricati su Netflix su una scheda SD.

Scopri come registrare lo schermo sui telefoni OPPO in modo semplice e utile, seguendo questa guida chiara.

Scopri come sfocare i contenuti multitasking sui telefoni Xiaomi per migliorare la sicurezza dell

Scattare foto selfie sui telefoni Xiaomi è una funzionalità disponibile sui telefoni con installata l

Google Instant Apps (noto anche come Google Play o Android Instant Apps) è un metodo efficace per scaricare e utilizzare le app senza installazione completa, migliorando l

Se stai cercando un modo rapido per annotare appunti sul tuo telefono Android, i widget della schermata iniziale sono la soluzione migliore.

Scopri 4 semplici modi per copiare e incollare testo su Android, comprendendo anche funzionalità avanzate e suggerimenti utili.

Ecco i modi per correggere l